| Version 18 (modified by waue, 17 years ago) (diff) |

|---|

實作一: Hadoop 單機安裝

tar.gz 安裝法

- 本實作基於 Ubuntu 8.04 LTS 版本,關於 Ubuntu 8.04 的安裝程序,請參考"Ubuntu 8.04 Server 版安裝步驟?"。

- 本課程實作之電腦教室所提供的作業環境是 Ubuntu 8.04 Server 版加裝 xubuntu 桌面的環境,登入資訊請留意講師說明。

- 本頁面的部分指令,是針對不熟悉 Linux 文字編輯器的使用者所設計的'懶人'設定法,您也可以使用習慣使用的文字編輯器(如:vi,nano,joe等)進行修改。

- 這個頁面,黑底白字的部分為指令,請自行剪貼提示符號 "$"(代表一般使用者) 或 "#"(代表最高權限 root 管理者) 之後的指令。

- 首先,由於 Sun Java Runtime 是執行 Hadoop 必備的工具,因此我們需要安裝 JRE 或 JDK。這裡我們直接安裝 JDK,因為後面寫程式仍舊需要用到 JDK 所提供的編譯器。目前 Ubuntu 8.04 提供的 JDK 套件最新版本為 Sun Java(TM) Development Kit (JDK) 6.06 ,套件名稱為 sun-java6-jdk。

~$ sudo apt-get install sun-java6-jdk

- 其次,請至國網中心 TWAREN 的鏡射站下載 Hadoop 0.18.3,並解開壓縮檔到 /opt 路徑。

~$ cd /opt /opt$ sudo wget http://ftp.twaren.net/Unix/Web/apache/hadoop/core/hadoop-0.18.3/hadoop-0.18.3.tar.gz /opt$ sudo tar zxvf hadoop-0.18.3.tar.gz /opt$ sudo mv hadoop-0.18.3/ hadoop

- 進入 hadoop 目錄,做進一步的設定。我們需要修改兩個檔案,第一個是 hadoop-env.sh,需要設定 JAVA_HOME, HADOOP_HOME, HADOOP_CONF_DIR 三個環境變數。

/opt$ cd hadoop/ /opt/hadoop$ sudo su /opt/hadoop# cat >> conf/hadoop-env.sh << EOF export JAVA_HOME=/usr/lib/jvm/java-6-sun export HADOOP_HOME=/opt/hadoop export HADOOP_CONF_DIR=/opt/hadoop/conf EOF

- 第二個設定檔是 hadoop-site.xml,由於官方所提供的範例並無法直接執行,因此我們參考線上文件,做了以下的修改。

/opt/hadoop# cat > conf/hadoop-site.xml << EOF <configuration> <property> <name>fs.default.name</name> <value>hdfs://localhost:9000</value> <description> The name of the default file system. Either the literal string "local" or a host:port for NDFS. </description> </property> <property> <name>mapred.job.tracker</name> <value>localhost:9001</value> <description> The host and port that the MapReduce job tracker runs at. If "local", then jobs are run in-process as a single map and reduce task. </description> </property> </configuration> EOF - 以上我們已經設定好 Hadoop 單機測試的環境,接著讓我們來啟動 Hadoop 相關服務。首先需要先格式化 namenode,接著用 start-all.sh 來啟動所有服務,包含 namenode, datanode, secondarynamenode, tasktracker

/opt/hadoop# bin/hadoop namenode -format /opt/hadoop# bin/start-all.sh

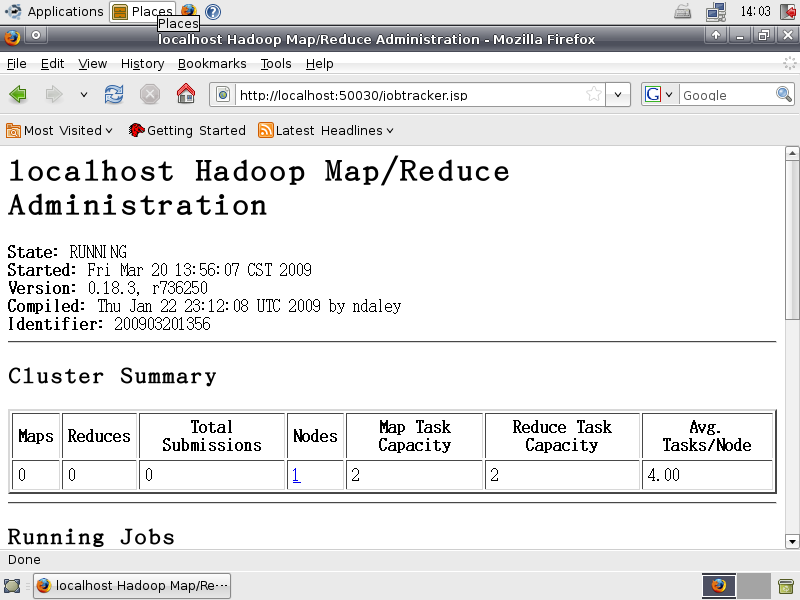

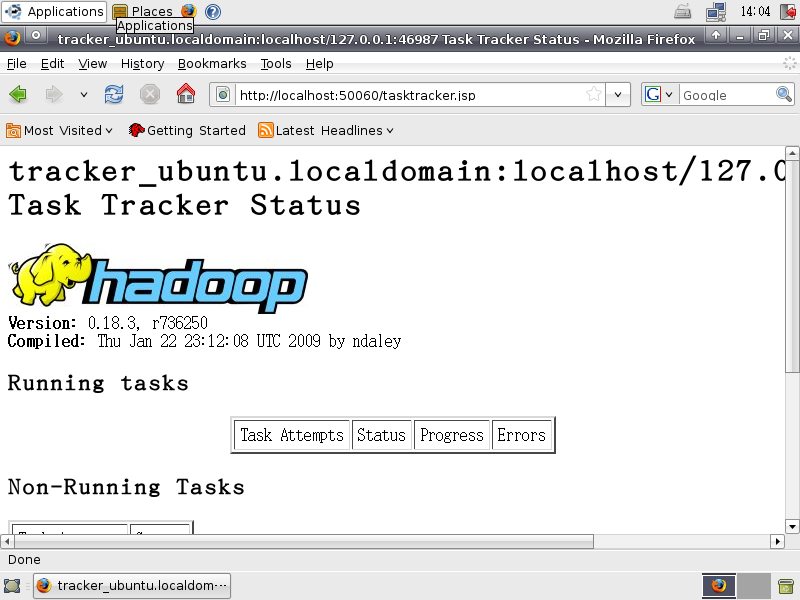

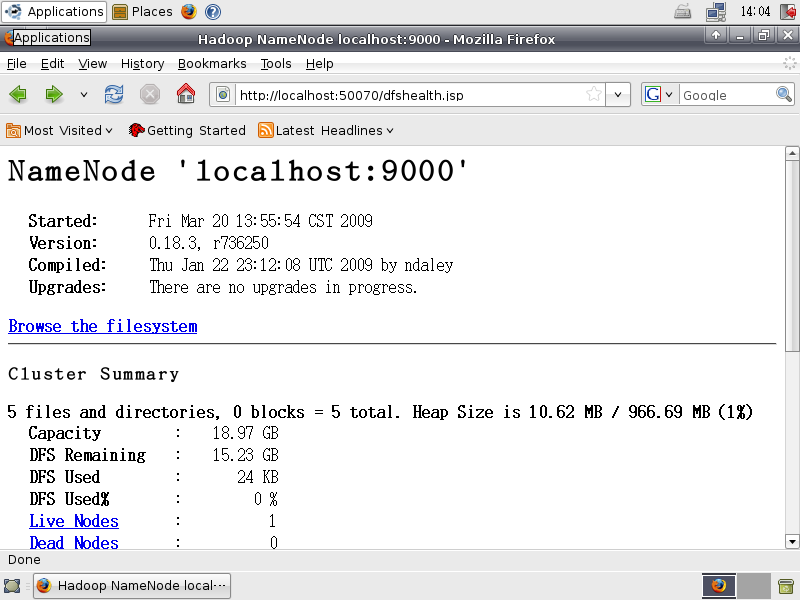

- 啟動之後,可以檢查以下網址,來觀看服務是否正常。

- http://localhost:50030/ - Hadoop 管理介面

- http://localhost:50060/ - Hadoop Task Tracker 狀態

- http://localhost:50070/ - Hadoop DFS 狀態

deb 套件一步安裝法

Attachments (3)

- hadoop_administration.png (58.5 KB) - added by jazz 17 years ago.

- hadoop_task_tracker.png (95.0 KB) - added by jazz 17 years ago.

- hadoop_dfs_status.png (53.3 KB) - added by jazz 17 years ago.

Download all attachments as: .zip